Repenser le LLM d'entreprise : une IA sécurisée et rentable

Alors que l'IA joue un rôle central dans l'innovation des entreprises, la décision entre les grands modèles linguistiques (LLM) basés sur le cloud et sur site est plus cruciale que jamais. Si vous recherchez des moyens de tirer parti des LLM d'entreprise sans compromettre la sécurité des données ou le contrôle des coûts, vous êtes au bon endroit.

Dans ce guide, j'expliquerai comment le déploiement local de LLM offre des avantages distincts, notamment en termes d'augmentation des données confidentialité des solutions d'IA économiques. À la fin, vous comprendrez pourquoi de plus en plus d'organisations déploient leur IA en interne et comment vous pouvez, vous aussi, rendre le déploiement de LLM de votre entreprise à la fois sécurisé et efficace. Commençons !

Introduction à l'Enterprise LLM : tendances et défis

Ces dernières années, les grands modèles linguistiques d'entreprise (LLM) ont gagné en popularité, révolutionnant la façon dont les organisations interagissent avec les données et les interprètent. Les entreprises s'appuient généralement sur des LLM basés sur le cloud, qui offrent évolutivité et accessibilité immédiate. Cependant, à mesure que les problèmes de sécurité des données augmentent, de plus en plus d'organisations envisagent des modèles en langue locale pour conserver les données plus près de chez elles. Cette évolution vers les déploiements LLM sur site reflète une demande croissante en matière de confidentialité, de contrôle et de conformité, en particulier dans les secteurs réglementés tels que la santé, la finance et le droit.

Explorons comment repenser les stratégies LLM basées sur le cloud pour un déploiement local peut permettre de relever ces défis émergents.

Pourquoi les modèles linguistiques locaux gagnent en popularité

L'attrait des modèles en langue locale réside dans leur capacité à répondre aux principaux besoins des entreprises en matière de confidentialité et de contrôle des données. Contrairement aux LLM hébergés dans le cloud, qui nécessitent l'envoi de données hors site, les modèles sur site permettent aux organisations d'héberger des solutions d'IA directement au sein de leur infrastructure. Cette fonctionnalité est essentielle pour les secteurs qui traitent des informations sensibles ou exclusives.

Les déploiements LLM sur site permettent aux entreprises de se conformer à des normes réglementaires strictes, car les données sont traitées et stockées sur site, limitant ainsi l'exposition aux réseaux externes. En donnant la priorité à la confidentialité des données d'entreprise, les organisations peuvent bénéficier de l'IA sans compromettre la confidentialité.

RAG dans les LLM d'entreprise : amélioration de la précision et de l'efficacité

L'un des principaux avantages du déploiement de LLM sur site est la possibilité d'intégrer des techniques de génération augmentée par extraction (RAG), améliorant ainsi la capacité de l'IA à fournir des réponses précises et pertinentes au contexte. RAG associe des modèles linguistiques à un système de récupération, permettant aux entreprises d'extraire des données de sources spécifiques et fiables en temps réel. Cette méthode est particulièrement utile dans les secteurs sensibles aux données, où les LLM peuvent générer des réponses fondées sur des informations sécurisées et à jour stockées localement.

Grâce à RAG, les organisations utilisant les solutions LLM sur site de QAnswer peuvent améliorer la précision des réponses tout en garantissant la confidentialité des données et leur conformité aux normes internes. Cette fusion de la récupération et de la génération renforce encore l'attrait des modèles en langue locale pour les entreprises qui recherchent à la fois des performances améliorées et une confidentialité des données robuste.

L'avantage en matière de sécurité des LLM sur site

L'un des principaux avantages des déploiements LLM sur site est le niveau de sécurité accru qu'ils offrent. Les LLM basés sur le cloud peuvent être vulnérables aux violations de données, car les informations sensibles doivent voyager vers et depuis des serveurs tiers. Grâce aux LLM sur site, les entreprises conservent le contrôle exclusif de leurs données. Cela est particulièrement utile dans les secteurs où la confidentialité des données et la confidentialité des données d'entreprise ne sont pas négociables.

Chez The QA Company, notre plateforme QAnswer prend en charge des configurations sécurisées qui permettent de conserver toutes les interactions entre les données au sein du pare-feu de l'entreprise, de minimiser les risques associés à l'accès de tiers et de garantir la conformité aux politiques internes de protection des données.

Performances des LLM sur site par rapport aux solutions basées sur le cloud

Contrairement à l'hypothèse selon laquelle les modèles basés sur le cloud sont intrinsèquement supérieurs, les LLM sur site peuvent offrir des niveaux de performance comparables, voire supérieurs, à leurs homologues du cloud. En exécutant des modèles au sein de leurs propres réseaux, les entreprises peuvent optimiser les performances des modèles en langue locale en fonction des spécifications de leur infrastructure.

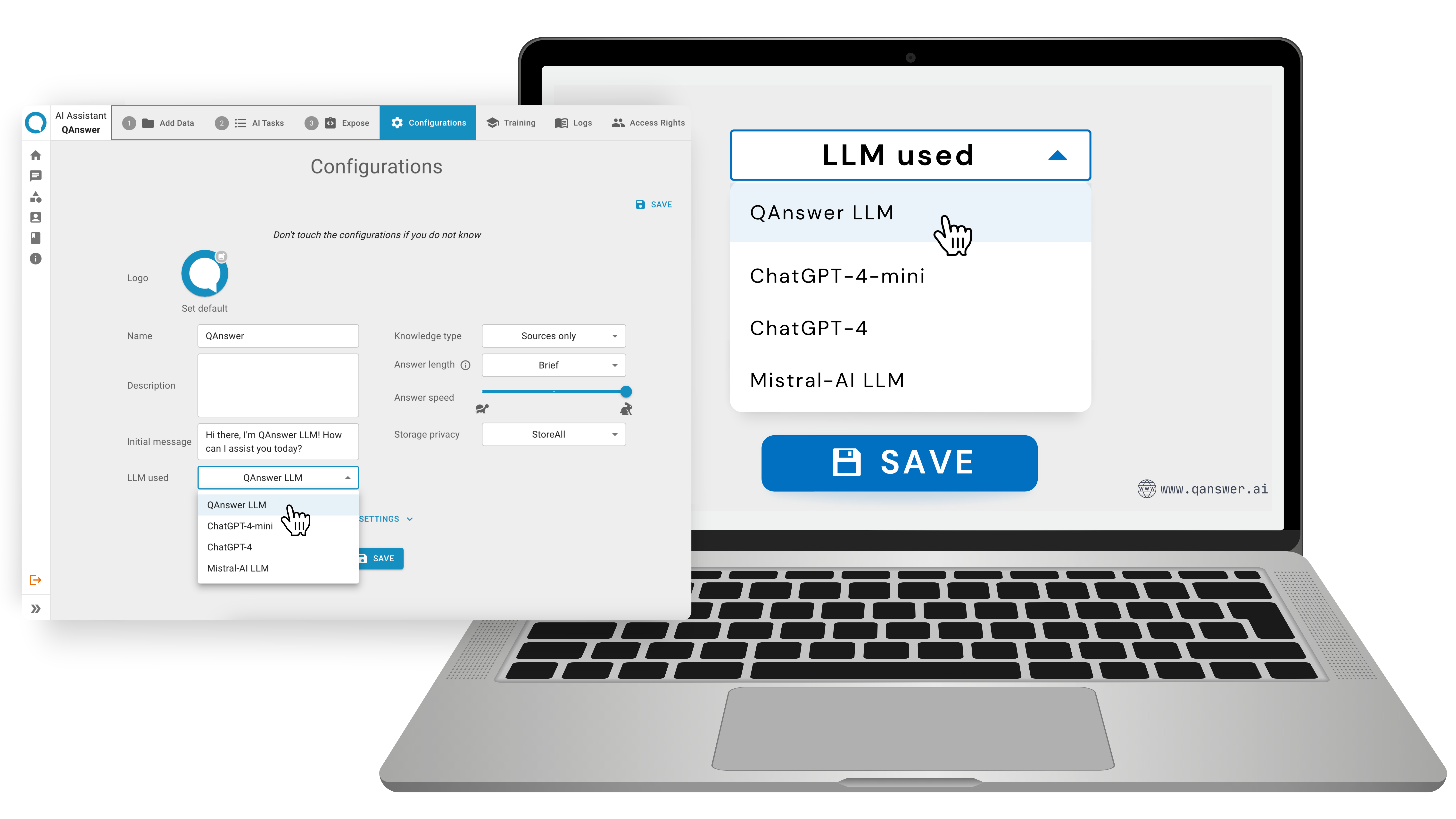

Avec QAnswer, les entreprises ont accès à une gamme de LLM qu'elles peuvent configurer et tester sur la même plateforme. Cette flexibilité permet de comparer facilement le QAnswer LLM aux LLM populaires basés sur le cloud tels qu'OpenAI LLM et Mistral LLM. Ces comparaisons permettent aux entreprises d'adapter leurs performances à leurs besoins spécifiques.

Avantages de la gestion des coûts grâce aux déploiements locaux de LLM

Le passage à des déploiements LLM sur site n'est pas seulement une question de sécurité et de contrôle des données, c'est également un choix rentable. Les Cloud LLM sont souvent assortis de frais d'abonnement récurrents, qui peuvent s'accumuler de manière significative au fil du temps, en particulier pour les besoins de données à grande échelle. Grâce à des modèles linguistiques locaux, les entreprises peuvent éviter ces coûts permanents. En effectuant un investissement ponctuel dans l'infrastructure, les organisations obtiennent une prévisibilité budgétaire et des économies de coûts sur le long terme.

Les options LLM sur site de QAnswer permettent aux entreprises de maintenir la stabilité de leur budget tout en obtenant des performances d'IA de haute qualité sans frais supplémentaires liés au cloud.

Les options de déploiement polyvalentes de QAnswer en matière de LLM

La plateforme QAnswer apporte une flexibilité unique aux déploiements LLM en entreprise. Il prend en charge plusieurs LLM, permettant aux entreprises de basculer facilement entre différents modèles, qu'ils soient open source ou disponibles dans le commerce. Par exemple, les entreprises peuvent tester le QAnswer LLM aux côtés de modèles populaires tels que OpenAI LLM ou Mistral, sans avoir à quitter la plateforme.

Cette polyvalence permet aux entreprises d'expérimenter, d'optimiser et de personnaliser de grands modèles de langage en fonction de leurs besoins commerciaux spécifiques. En fournissant une plate-forme unique pour la gestion du LLM, QAnswer rend l'expérimentation de modèles accessible et simple.

Secteurs bénéficiant des déploiements locaux de LLM

Certains secteurs, tels que la santé, la finance, les secteurs publics et le droit, ont des exigences strictes en matière de sécurité des données et de confidentialité des données d'entreprise. Ces secteurs devraient bénéficier de manière significative des déploiements locaux de LLM, dans le cadre desquels les données sensibles ne quittent jamais l'infrastructure de l'entreprise.

Dans le secteur de la santé, par exemple, les données des patients peuvent rester sécurisées au sein de l'établissement tout en bénéficiant de diagnostics et de recherches d'informations basés sur l'IA. De même, les sociétés financières peuvent s'assurer que les données des clients restent privées tout en utilisant les LLM pour l'évaluation des risques ou la détection des fraudes. Les cabinets juridiques peuvent tirer parti des LLM sur site pour analyser de grands volumes de dossiers juridiques sans compromettre la confidentialité des clients.

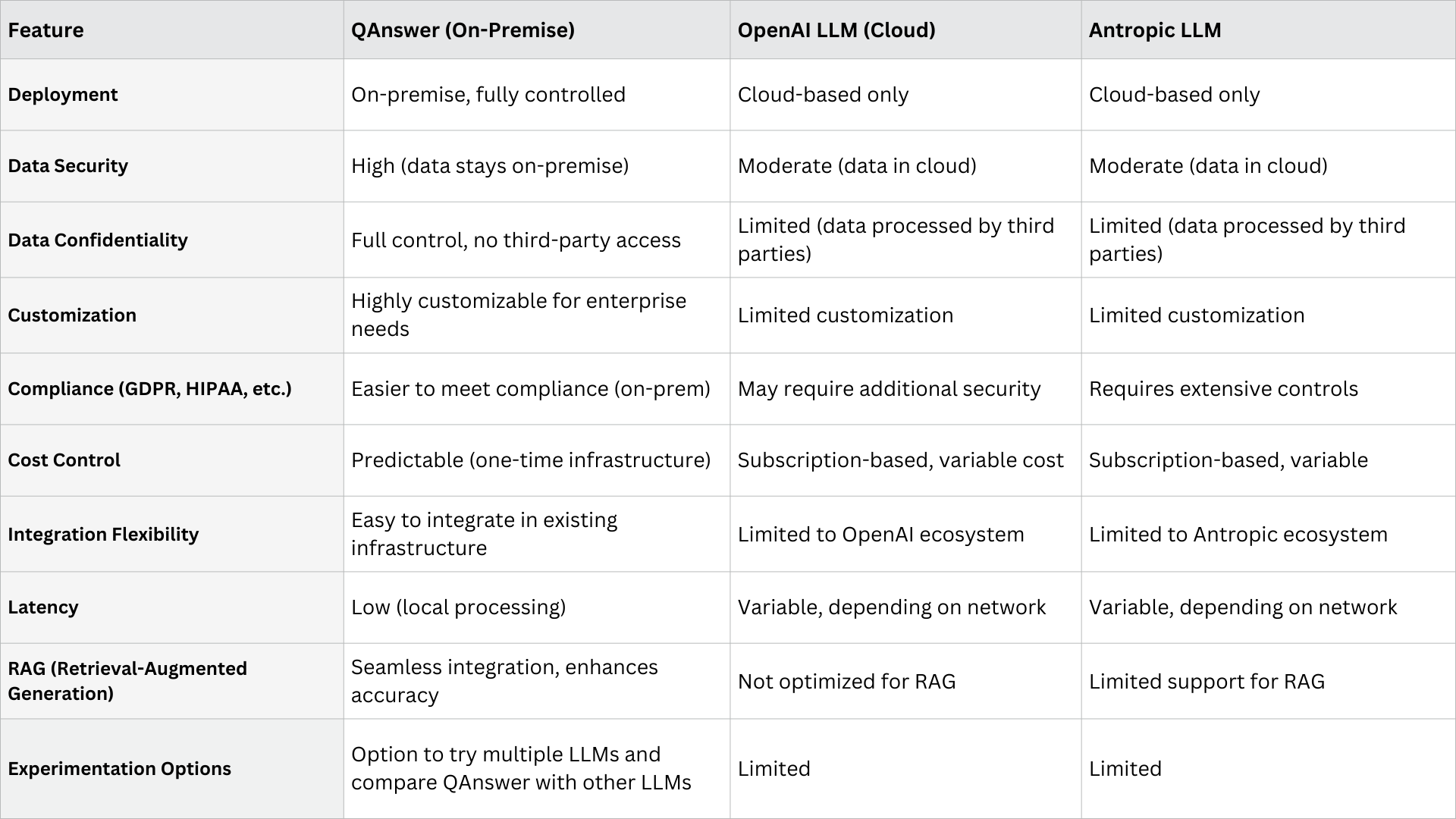

Comparaison de la LLM sur site de QAnswer avec d'autres modèles basés sur le cloud

Approfondissez vos connaissances grâce à une étude comparative des grands modèles linguistiques (LLM) les plus prometteurs et les plus largement utilisés d'aujourd'hui.

Points clés à retenir : pourquoi répondre ?

La solution sur site de QAnswer offre aux entreprises un niveau élevé de sécurité des données, de confidentialité et de contrôle de conformité que les LLM basés sur le cloud ne peuvent souvent pas atteindre. Avec des options d'intégration flexibles et une latence plus faible pour le traitement local, QAnswer est idéal pour les industries qui accordent la priorité à la confidentialité des données et à la prévisibilité des coûts.

Voici un aperçu des principaux avantages :

- Sécurité des données améliorée: Maintient les interactions entre les données entièrement dans le pare-feu de l'entreprise, minimisant ainsi l'accès des tiers et protégeant les informations sensibles.

- Contrôle et conformité complets: Le déploiement sur site répond à des normes strictes de confidentialité des données, ce qui le rend idéal pour les secteurs réglementés tels que la santé, la finance, le secteur public et le droit.

- Rentabilité: Réduit les dépenses à long terme en éliminant les frais d'abonnement récurrents au cloud, ce qui permet de stabiliser le budget grâce à un investissement ponctuel dans l'infrastructure.

- Performances comparables: Offre des performances comparables à celles des LLM cloud, optimisées pour tirer parti de l'infrastructure existante pour un traitement local rapide et fiable.

- Flexibilité avec plusieurs LLM: prend en charge divers LLM (QAnswer LLM, OpenAI LLM, Mistral LLM, etc.), permettant des tests, des expérimentations et des personnalisations fluides au sein d'une plateforme unifiée.

- Latence réduite: le traitement local permet d'accélérer les temps de réponse, ce qui est essentiel pour les applications en temps réel et l'amélioration de l'expérience utilisateur.

Conclusion

La transition vers les LLM sur site représente une nouvelle ère pour l'IA d'entreprise, où confidentialité des données, rentabilité et performances coexistent. En déployant des modèles en langue locale, les entreprises obtiennent le contrôle total de leurs données tout en minimisant les risques liés aux tiers. Grâce à la flexibilité offerte par QAnswer, les entreprises peuvent expérimenter différents modèles de langage de grande envergure, optimisant ainsi les performances sans compromettre la confidentialité des données d'entreprise.

Commencez à explorer les avantages des LLM sur site dès aujourd'hui et libérez un nouveau potentiel d'IA au sein de votre propre infrastructure.

Découvrez comment QAnswer peut dynamiser votre entreprise grâce à l'IA. Communiquez avec info@the-qa-company.com

Visitez notre site Web pour découvrir comment QAnswer favorise la transformation des entreprises grâce à l'IA : www.qanswer.ai

Essayez QAnswer dès aujourd'hui et découvrez ses fonctionnalités de première main : https://app.qanswer.ai/

Merci ! À bientôt pour de nouvelles mises à jour.